CCF YOCSEF成都成功举办“跨模态智能技术的进展、困境及趋势”技术论坛(线上)

2022年4月9日14时,CCF YOCSEF成都“跨模态智能技术的进展、困境及趋势”技术论坛成功举办。论坛由中国计算机学会主办,CCF YOCSEF成都学术委员会承办,英特尔亚太研发有限公司与广州粵嵌通信科技股份有限公司赞助支持。电子科技大学计算机科学与工程学院李文、西南交通大学计算机与人工智能学院袁召全担任论坛执行主席,四川农业大学周蓓担任线上主席。本次技术论坛邀请了六位嘉宾分享观点、180多位专家参与在线讨论。

近年来,深度学习在单一模态的智能分析领域取得重大进展,但在跨模态统一表征、跨模态推理、多模态关联与融合、工业应用落地等方面仍然面临极大的挑战性。针对这些问题,论坛以跨模态智能技术的进展、困境与趋势为主题展开深入研讨。本次论坛的引导发言嘉宾有南京邮电大学鲍秉坤教授、电子科技大学宋井宽教授、南京理工大学李泽超教授、上海科技大学高盛华研究员、四川大学雷印杰教授和阿里巴巴高级算法专家葛铁铮博士。

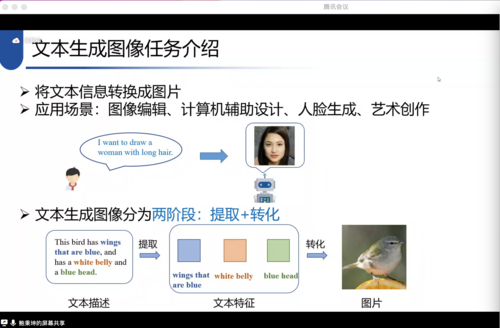

鲍秉坤教授以《跨模态图像生成》为题,首先介绍了目前主流文本-图像生成方法的基本框架与研究进展。面对海量的多模态数据,鲍秉坤教授指出目前在文本-图像生成上的三个主要任务挑战,并提出相应的解决思路:第一,针对于文本和视觉两个模态的特征融合难的挑战,提出建立新颖的文本-图像特征深度融合网络,使生成器在融合文本和图像特征时更加充分地利用文本语义信息,增加融合的表示空间;第二,针对图片和文本的语义信息不对等的挑战,在生成器和再描述模块中引入对抗学习,保持文本和语义的一致性;第三,针对文本特征到图片像素的转换不易控制,从而导致错误的特征转换的挑战,提出建立新的文本-图像交互方式,对齐文本关键特征和图像关键特征,更好的控制全局和局部信息,提高文本对图像编辑的准确性。除此之外,鲍秉坤教授还指出,在未来的研究中应该实现由简单图像生成到复杂图像生成的应用场景转变、寻求更加丰富多样的图像生成模式,以及探索更加精细的评价指标。

图 1 南京邮电大学通信与信息工程学院鲍秉坤教授引导报告

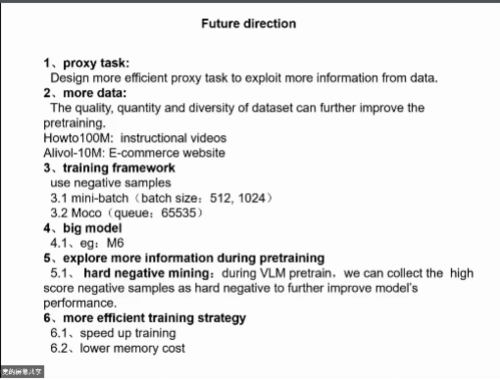

宋井宽教授以《多模态预训练模型》为题,系统性地介绍了Transformer的背景和原理,从网络架构出发,基于是否共享相同编码器的结构设计,分别讲解了目前具有代表性的多个单塔和双塔模型,从数据集、代理任务和下游任务多个方面对跨模态自监督学习的预训练主要流程进行了概括。同时,宋井宽教授指出,跨模态预训练未来的研究方向包括:(1)设计更高效的代理任务,从数据中挖掘更多的信息。(2)在数据层面上,更大的数据量、更高的数据质量,以及多样性都能够提升跨模态预训练模型的性能。(3)选取更高效的训练框架,比如引入对比学习等理论和方法。(4)研究更大的模型和挖掘更难训练的样本。(5)探索更高效的训练策略,加速训练过程并减少计算开销。

图 2 电子科技大学计算机科学与工程学院宋井宽教授引导报告

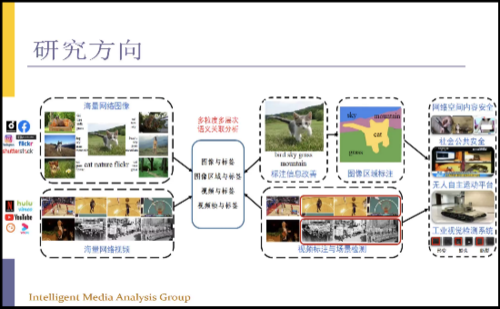

李泽超教授以《受限环境跨模态内容分析与识别》为题,指出跨模态智能理解的本质问题是计算机对于获取的图像的视觉表示与用户对于图像内容的高层语义理解之间的差异,也即语义鸿沟。李泽超指出,跨模态分析所面临的实际应用场景通常是受限的,包括识别粒度细、应用场景丰富、数据分布差距大、有限的计算资源和标注数据等,这就要求设计的方法在受限环境具有好的特征提取能力和泛化能力。针对受限环境下跨模态内容理解问题,李泽超教授介绍了他们解决思路:(1)在小样本条件下,他们借助类别标签的语义知识进行基本类和新类之间的知识迁移,同时引入图卷积神经网络来对类别间的关系进行建模,进一步地利用文本信息来增强视觉分辨能力;(2)在弱监督条件下,分别提出弱监督语义引导的哈希方法和基于遮挡视觉-语义图推理的哈希方法,从有噪声的便签中挖掘视觉-语义信息。同时,他们还研究了弱监督图像理解的统一框架,基于联合学习,进一步消除图像和标签的差异性。

图 3 南京理工大学计算机科学与工程学院李泽超教授引导报告

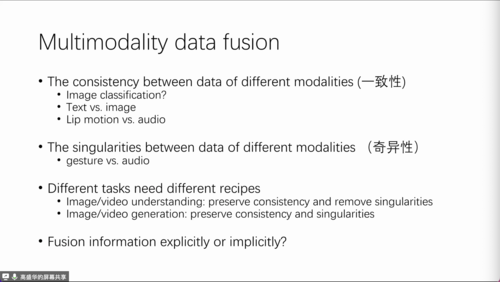

高盛华研究员就《显示融合还是隐式融合—浅谈多模态数据用于图像理解和视频生成任务》做了引导性报告。高盛华研究员主要介绍了他们在以下三个方面的研究工作:(1)针对人群计数任务中的小目标检测性能差且人工标注困难的问题,提出显式地融合深度信息,进而生成有效的高斯密度图。(2)在视觉定位任务上,与传统的两阶段方法不同,他们提出显式物体检测和异步图像定位的单阶段方法,进一步的刻画图像和文本的对应关系。同时,使用图神经网络来刻画图像中物体之间的关系。(3)在手势生成任务上,他们认为人嘴和语言之间具有一一对应的一致性,可以针对姿势进行建模,但同时应该保持姿态和手势的多样性。在多模态数据具有多样性的背景下,他认为应该深度理解数据并根据任务来进行不同模态之间的显式或隐式融合。同时,不同的任务对于不同模态的数据应该具有不同的处理策略,比如在图像/视频理解任务中应该刻画一致性而消除奇异性,但对于图像/视频生成任务则应该保留奇异性。

图 4 上海科技大学信息学院高盛华研究员引导报告

雷印杰教授以《跨域和跨模态适应学习的视觉理解》为题,首先概括了跨域学习和跨域跨模态适应学习的特点,然后针对于各个模态数据跨域的不匹配问题,介绍了相应的解决方案:(1)由于目前视觉模型倾向于学习图片的纹理特征,提出对局部和全局纹理特征进行有效建模的方法,实现跨域的数据增强。(2)现有域适应方法关注单一模态,而三维数据集往往是多模态的,比如三位点云数据和二维图像。针对该问题,提出在各自的模态中共同学习对应的特征,互相促进,从而实现跨域的跨模态学习。(3)为了增强类别之间的分离性,有效学习领域不变性,提出语义感知和语义感知白化,进行语义对齐。(4)基于GTA-V构建了一个大规模合成点云场景流估计数据库,并在此基础上提出一种基于跨域一致性学习的合成-真实的点云场景流估计方法。

图 5 四川大学电子信息学院雷印杰教授引导报告

最后,葛铁铮博士以《多模态技术在电商广告中的应用》为题,指出电商商品包含图像、视频、文本等多种模态数据,数据丰富且具有对应关系,他认为跨模态智能分析在电商广告中具有非常可观的前景,介绍了四个实际应用:(1)在视频解说中,可以利用多模态数据,实现长文案生成,从而提升视频的吸引力,但目前仍存在有准确性和对应性不足的问题。(2)基于图上内容的文案生成任务,用于图片添加文本信息,形成图文创意,但存在相邻文案语义重复和图片内容连接性不足的问题。(3)针对于视频剪辑的时长、尺寸不合要求的问题,添加商品图片和标题进行跨模态的时空搜索,从而获得更合适的视频广告,但其存在解释性差的问题。(4)将内容模型作为启动先验,基于图片内容进行创意优选,但这类方法易被投放效果主导,且没有实现用户个性化建模。葛铁铮博士认为,虽然目前跨模态分析在工业界具有广泛的应用前景,但是也存在许多需要解决的问题,真正实现落地仍然需要工业界和学术界一起做出更大的努力。

图 6 阿里巴巴高级算法专家葛铁铮博士引导报告

本次论坛就跨模态智能技术的两个议题进行思辨讨论,六位嘉宾及参会人士纷纷阐述了自己的观点。

议题一:跨模态智能的研究是方兴未艾还是末路穷途?

经线上思辨讨论,议题一主要可以归纳为如下观点:(1)跨模态在检索、广告、生成等领域已经具有广泛的应用,结合多模态互补信息的方法往往表现出比单一模态方法更好的性能。(2)目前跨模态智能主要有基于大模型预训练的方法和基于认知机理建模的方法两种技术路径。从大模型的角度,我们需要评估其能力边界。从认知启发建模的角度,目前还有非常多亟待解决的难题。未来究竟哪类方法是通向跨模态强人工智能的道路,还有待进一步探索。(3)从智能程度的角度,当前的跨模态智能技术还在感知层面,距离类人类具有的跨模态推理、想象等高级智能还差很远,还有很长的路要走。(4)从跨模态研究范式的角度,当前还没有明确的理论做支撑。相对于单模态的智能技术,跨模态智能还没形成自己独有的理论框架,还需要进一步探索与思考与单模态问题的本质区别。

议题二:跨模态智能是应用引领研究还是研究驱动应用?

经线上思辨讨论,议题二主要可以归纳为以下几种观点:(1)研究成果不能仅仅是方法上的创新,应用落地才能发挥研究的真正价值。在跨模态智能领域,目前还没有很多成熟的应用和产品。研究人员应使研究向应用靠拢,吸引更多的工业界的关注和更多研究者,与此同时,工业界也可以给予高校科研更多的建议。(2)跨模态分析领域的研究尚处于基础阶段,还缺少很多理论支撑,还未达到成熟的工业应用阶段。(3)理论研究和应用应该呈现螺旋式上升的模式,两者从不同层面推进,不论哪一方取得突破,都会促进另一方的进步。(4)国情会决定科研和工业界的生态,“国家+企业+高校”的三方相互合作、相互支持的模式是目前符合我国国情的一种研究生态,对于跨模态智能的研究与应用发展也是如此。

最后,由本次论坛执行主席袁召全和YOCSEF成都现任主席彭博就主题为“跨模态智能技术的进展、困境及趋势”的本次论坛进行了总结发言,并致谢CCF YOCSEF总部,CCF YOCSEF成都学术委员会,同时感谢来参与本次论坛的各位嘉宾和参会者以及英特尔亚太研发有限公司、广州粵嵌通信科技股份有限公司对本次活动的大力支持。