CNCC2024——因果推断与大模型未来

什么是下一代大模型标志性特征?可解释?可泛化?可推理?当前大模型的泛化能力主要是通过对数据和知识的见多识广,而因果推理实现泛化的机制则是学习因果不变性,以不变应万变,大模型和因果两种泛化机制能否实现1+1>2?大模型本质还是数据驱动关联学习机制,如何实现由关联到因果的跨越,提升大模型的可信能力?同时大模型也为因果推理带来了新的机遇,如何结合大模型和世界知识,为因果推断和因果发现助力?因果推理与大模型如何双向赋能?

针对这些问题,论坛邀请了来自于因果推理、大模型、人工智能、统计等领域的顶尖科学家、企业家和技术领导者,共同研讨(1)什么(不)是下一代大模型标志性特性?(2)因果推理在下一代大模型中的必要性和作用?(3)因果推理赋能下一代大模型的技术路径?

通过此次论坛,我们期望形成“我国因果与下一代大模型的总体研究路径”,输出给相关部门助力形成“因果与大模型”领域项目指南,以及输出CCF专辑或白皮书,对研究界进行牵引和动员。

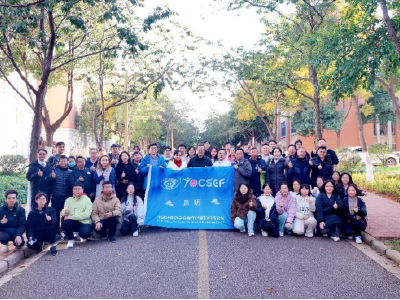

图 1 与会嘉宾合照

此次论坛由2024中国计算机大会(CNCC)主办,由CCF YOCSEF杭州学术委员会组织,由CCF副秘书长兼青工委主任崔鹏和CCF YOCSEF杭州副主席况琨共同担任执行主席,邀请北京工商大学/北京大学耿直教授、复旦大学邱锡鹏教授作为引导嘉宾。

此次论坛活动讨论热烈,持续4个小时,广东工业大学蔡瑞初、深圳大学陈小军、哈尔滨工业大学丁效、华为/天津大学郝建业、重庆大学刘礼、上海人工智能实验室陆超超、国防科技大学王浩天、合肥工业大学吴乐、上海财经大学徐韧喆、国防科技大学杨文婧、华为叶君健、合肥工业大学俞奎、华东师范大学张敏等高校和企业界嘉宾到场,累计超过100人参会。

图 2论坛现场

论坛执行主席崔鹏和况琨首先介绍了此次论坛背景、引导嘉宾,对与会嘉宾表示感谢。接下来会议进入引导发言环节。

——引导发言——

一、前瞻性与回顾性因果推断

图 3北京工商大学/北京大学耿直教授做引导发言

耿直教授指出,因果推断是一个历久弥新的课题,早在2000年前人类就开始研究因果关系的方法。从巫术、占星术到亚里士多德的逻辑推理,再到文艺复兴时期科学实验的兴起,因果推断一直是推动人类科学进步的关键议题。

耿教授分析了因果推断在历史上多次方法上的演变,他指出,人工智能的出现给因果则提供了新的探索机会。然而,目前的人工智能方法多以相关性为基础,缺乏从根本上揭示因果关系的能力。因此,他希望在大模型和深度学习的帮助下,未来能从复杂的数据中提炼出真正的因果关系,这不仅有助于科学研究,也将对人工智能的发展产生深远影响。

耿教授指出,因果推断主要涉及四个方面:因果概念的意义、推导结果的原因、了解因果机制、评价因果作用。针对这些方面,他阐述了回顾性因果分析的挑战,尤其是在寻找合适的“对照”方面的难度。耿教授通过吸烟与肺癌的例子生动解释了对照实验的重要性,以及如何在前瞻性和回顾性因果推断中处理相关性和干预效果。他强调了在回顾性因果推断中,如何通过严谨的数据假设和条件概率来实现因果关系的推断,指出这一领域未来的发展潜力。

耿教授还特别提到,此次参会的主要目的是探讨如何将大模型应用于因果推断研究。他认为,若未来人工智能能结合因果推理能力,将可能真正实现超越人类的智能。他期待通过此次会议,与各位学者探讨因果推断的最新进展,为统计学与计算机科学的交叉研究找到新的思路。

二、从大语言模型到世界模型

图 4复旦大学邱锡鹏教授与听众讨论

邱锡鹏教授对大语言模型(LLM)未来的发展方向进行了深刻的思考与反思。他指出,当前的大模型在生成内容方面采用自回归模式,即逐步预测下一个词元,但缺乏对生成结果的反思和验证。这种结构导致模型在处理长序列任务时容易产生累积误差。此外,现在的大模型缺少一套更具交互性的“世界模型”来反馈和指导,进一步限制了模型的通用性与适应性。

邱教授认为,当今大模型的一项重要突破是其广泛的通用性。与传统人工智能专注于单一任务的训练方式不同,大语言模型能够广泛适用于多种任务,为实际应用提供了灵活的解决方案。语言作为人类知识的结晶,通过数千年文明的积累,形成了一种高效的信息传达方式。邱教授强调,语言不仅是信息的载体,更是人类对世界观察的压缩。他认为这种语言框架为大模型提供了通用性支撑,而大语言模型的潜力在于能否进一步模拟人类的知识结构,成为一种具备深度理解和世界认知的“世界模型”。

针对大模型的局限性,邱教授引用了两位著名学者的观点。OpenAI的Jason Wei总结道,大模型目前在长序列推理、算术运算、个性化知识和实时信息方面存在明显不足;而Yann LeCun则指出,自回归生成的累积误差使得模型难以生成连贯且准确的长序列内容。邱教授认为,为了克服这些挑战,未来的大模型必须引入反思机制,例如在推理过程中进行搜索与回溯,类似OpenAI o1模型的结构性优化,以应对复杂推理任务。

邱教授进一步探讨了“世界模型”的概念,即构建一种模拟人类的观察与推理系统。该概念最早由LSTM发明人Juergen Schmidhuber提出,其核心在于模拟智能体在虚拟环境中的交互与反馈,从而辅助决策并进行自我改进。例如OpenAI的Sora视觉模型便试图通过视觉和语言交互实现这种世界模拟。邱教授指出,具身学习和因果推断也可以借助世界模型来模拟实验环境,从而更加灵活地开展因果关系的探索。

展望未来,邱教授认为,大模型的发展将朝着“强交互”和“强推理”两个方向深化。他设想,未来的模型不仅要具备与现实世界的交互能力,还需要较强的推理能力,并通过世界模型的支持实现更高效的因果推断。这种能力将为模型赋予深度理解世界的潜力,使之在未来的人工智能领域中扮演更加关键的角色。

——思辨环节——

在引导报告之后进入思辨环节。与会嘉宾围绕“当代大模型存在哪些缺陷?下一代大模型应该具备哪些标志性特性?”、“因果推理在下一代大模型中的必要性和作用”、“ 因果推理赋能下一代大模型的技术路径”三个议题展开了深入思辨。

图 5思辨讨论现场

图 6现场观众参与讨论

思辨议题一:当代大模型存在哪些缺陷?下一代大模型应该具备哪些标志性特性?

与会专家们围绕这一议题展开了深入讨论,提出了如下观点:

当代大模型存在哪些缺陷:

Ø 数据质量和认知局限性:当前模型对低质量和偏颇的数据依赖较大,容易受到人类认知偏误影响,可能强化错误认知。此外,大模型缺乏与真实世界的直接交互,难以通过动态反馈进行认知更新,限制了对现实问题的适应性。

Ø 学习机制与智能水平的局限:现有大模型依赖scaling law提升性能,靠堆积数据和算力获得效果,缺乏高效、举一反三的学习机制。自回归生成方式导致推理过程中误差累积,缺乏反思和推理能力,不具备类人的自我纠错功能。

Ø 模型架构的单一性与任务适配问题:大一统的架构不适合处理不同任务的需求,如数学任务需要序列和优先级概念,语言任务更关注语义相似性。模型对特定任务的泛化能力较弱,难以有效处理低频、精细化的知识,尤其是在因果推理等领域。

下一代大模型应该具备哪些标志性特性:

Ø 主动数据获取与因果推理:大模型需具备主动获取数据的能力,通过与真实环境交互、因果干预等手段获得更高质量的数据,使模型在复杂现实中持续优化。

Ø 多模态学习与强推理能力:发展灵活的任务专用学习机制,针对不同任务需求(如相似性、序列性等)实现专用嵌入,并具备“慢思考”式的多步骤推理能力,从而保证推理的深度和一致性。

Ø 可解释性与安全性:增强模型的可解释性和安全性,融入价值判断,实现对行为和输出的伦理约束,使其符合人类社会的道德和法律标准。

思辨议题二:因果推理在下一代大模型中的必要性和作用

与会专家们围绕这一议题展开了深入讨论,大部分学者认可因果推理对下一代大模型的必要性,并提出了若干因果推理在下一代大模型的潜在作用:

提升数据质量与主动获取能力:

Ø 因果推理可用于主动获取高质量数据,通过干预和实验设计消除数据偏差和混杂因素。

Ø 结合具身智能,模型能够通过交互式干预获取因果关系,更准确地理解数据背后的机制。

改进学习机制,实现从相关到因果的转变:

Ø 当前大模型主要基于相关性进行学习,因果推理可以帮助模型理解变量间的因果关系,超越纯统计关联。

Ø 引入因果推理,可改变模型的学习范式,使其具备推理因果结构的能力,提高学习效率和效果。

提高模型的可解释性和可信度:

Ø 理解因果关系有助于模型提供决策依据,增强可解释性,使模型输出更具透明度。

Ø 因果推理可帮助模型避免不合理或有害的输出,确保行为符合人类的伦理和安全标准。

促进模型的泛化能力与零样本学习:

Ø 因果推理使模型能够更好地处理分布外任务,提高在未知环境下的泛化能力。

Ø 在缺乏直接经验的数据情况下,因果推理可帮助模型进行零样本学习和外推推理,解决新颖问题。

思辨议题三:因果推理赋能下一代大模型的技术路径

与会专家们围绕这一议题展开了深入讨论,提出了如下观点:

Ø 数据层面的因果融入:通过提示工程等手段,在数据输入层面引导大模型进行因果推理,减少幻觉和错误输出。

Ø 模型层面的因果改造:修改现有模型的组件,添加因果推理能力。例如,在Transformer架构中加入具备干预和反事实推理能力的模块。

Ø 构建具备内生因果推理能力的新模型:重新设计模型架构,开发具备因果推理和世界模型的全新大模型,突破仅预测下一个词的范式。

Ø 利用模拟环境和合成数据进行因果学习:在虚拟世界或模拟器中,通过交互和干预学习因果关系,将其迁移到现实世界中应用。

Ø 融合因果知识图谱和多模态数据增强模型能力:利用因果知识图谱,将文本、图像、语音等多模态数据中的因果信息整合到模型中,提高模型的理解和推理能力。

通过这次深入讨论、广泛思辨的论坛,线下嘉宾和观众了解到了在下一代大模型中引入因果推理的必要性,但确实也存在诸如模型架构改进、数据质量提升、技术路径探索等挑战,也集思广益了一系列解决方案。最后一致认为,因果推理赋能的下一代大模型应围绕提升模型的推理能力、可解释性和泛化能力展开,将因果推理更广泛地融入大模型的构建中,进一步推动人工智能的发展。