CCF YOCSEF重庆举办“科技之“智”赋能医疗之“治”:探索人类与AI在生物医疗领域的共存共生之道”观点论坛

生物医疗行业是关系国计民生、国家安全的战略性新兴行业,是健康中国建设的重要基础。人工智能(AI)既是引领未来的战略性技术,也是发展新质生产力的重要引擎。AI与生物医药的融合,不仅是技术的革命,更是对全人类健康的巨大贡献。

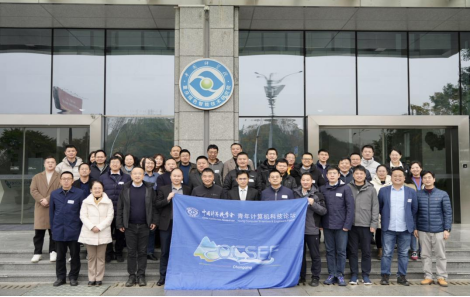

生物医学和人工智能结合会是未来人类社会最猛烈的科技革命之一,进而改变每一个人和社会。在实现这一宏伟目标的路径中,将面临诸多伦理与政策方面的挑战。CCF YOCSEF重庆于2024年12月13日在中国科学院重庆绿色智能技术研究院举办了“科技之‘智’赋能医疗之‘治’:探索人类与AI在生物医疗领域的共存共生之道”观点论坛,CCF YOCSEF重庆AC委员陈芋文和CCF YOCSEF重庆AC委员杨韬担任执行主席。来自CCF YOCSEF总部AC鄢兴雨、CCF YOCSEF重庆22-23主席贾韬、CCF YOCSEF重庆23-24主席桑春艳、CCF YOCSEF重庆21-22 副主席冯玉明等高校、科研院所、医疗单位和企业界相关专家学者40余人共聚一堂,共同研讨人类与AI在生物医疗领域的共存共生之道。

论坛执行主席陈芋文介绍了CCF YOCSEF文化,并简要介绍了举办此次论坛的背景。

在论坛引导发言环节中,引导嘉宾依次做了题为《因果学习及生物医学应用初探》、《医疗大数据与人工智能研究实践》和《面向医检互认的医学影像质量评价》的引导发言。

山东大学余国先教授作了题为《因果学习及生物医学应用初探》的引导发言。 国先首先从21世纪最具挑战性的125个问题、面向2020年代的计算机科学重大方向两个重要背景出发,说明生物分子间关联具有有向性、关联分析易受噪声和冗余因素影响,进而说明生命分子系统存在复杂的调控机制,利用因果关系可以得到简洁可靠的有向关系,且因果关系具有天然的指导作用,可以更好的帮助疾病溯源和病理解析;接下来国先结合其团队的实验结果和现实应用,简明扼要的介绍了局部因果学习研究、属性一直网络学习研究、多粒度因果学习研究成果;最后提出AI智能医疗助手如何与临床医生协作?如何定义AI医生决策规则两个问题,并阐述了其对两个问题的思考。

陆军军医大学第一附属医院医学大数据与人工智能中心主任汪鹏作了题为《医疗大数据与人工智能研究实践》的引导发言。汪鹏首先简要介绍了人工智能医疗的发展历程,表明人工智能在医疗影像、辅助诊疗、疾病预测预防、健康管理等场景具有革命性的潜力,然而在技术方面存在算法透明度不足、幻觉问题、数据质量不完备等问题,在标准方面存在缺乏统一规范、标准研究滞后等问题,对人工智能技术在生物医疗领域的应用具有较大的挑战。针对上述问题,西南医院医学大数据与人工智能中心依靠十四五建设规划,基于充足的医院数据资源,开展了医学大数据基础治理应用与能力开发平台、医学AI能力生成与应用服务平台等基础能力建设,通过技术更好的解决面临的医疗伦理问题,全方位提升AI支撑能力。

中国科学院重庆绿色智能技术研究院李正浩副研究员作了题为《面向医检互认的医学影像质量评价》的引导发言。李正浩表明医学影像的综合评估中,不仅影像本身需要关注,还涉及放射器参数、设备工作参数、患者个体信息等多维度数据。缺乏统一的质量标准和规范,导致数据质量、业务质量和检查质效三方面存在大量问题。如数据质量问题源于标准化不足和多源异构数据整合的复杂性。缺乏院前质量控制机制,无法对医疗过程中每一步骤的质量进行实时干预。当前的智能化诊断和服务覆盖范围虽广,但行业内尚无全面解决方案,存在优化和拓展空间。数据安全和共享在跨机构、跨区域互通中面临技术和伦理挑战。重庆在医检互认开展了较多的工作,完成了规范制定、系统研发与优化、院前质量控制、跨区域互联互通多个环节的工作,取得了良好成效。通过这些工作,获取了大量的先验经验和医疗数据,对计算机科学技术投入相关研究打下了数据与场景的基础。

在思辨环节中,参会人员对三个思辨问题展开了充分的讨论。

思辨议题一:在AI医生的辅助下否会削弱医生的专业判断能力?是否会导致医护人员失业?

思辨嘉宾重庆医科大学附属第一医院麻醉科主任魏珂主任,特邀嘉宾南京信息工程大学孙乐教授在讨论过程中首先指出在AI医生的辅助下肯定会降低医生的判断能力,医学是一个经验科学,无论从中西医学的诊疗方式,还是从学习到临床,依据的是个人的接触到的数据量,进而在问诊中得到结果。从麻醉科的现实工作中出发,从老一辈观察体征到现在自动监测,在某些层面上,已经影响到了年轻医生的部分能力。但是随着科技的发展,通过人工智能实现医疗方法的提升和治疗手段的提高,又成为必须。与会人员就该思辨点进行了讨论,内容主要包括:

1.AI作为辅助工具,增强而非削弱医生判断能力:与会人员普遍认为,AI技术在医疗领域的应用主要是作为医生的辅助工具,通过大数据分析和模式识别,帮助医生更快地诊断疾病和管理患者。AI可以处理大量数据,识别出潜在的模式和风险,为医生提供决策支持。这种技术的应用并不会削弱医生的专业判断能力,反而能够提高诊断的准确性和效率,使医生能够更加专注于患者护理和复杂决策。

2.AI与医护人员的协作,创造新的就业机会:讨论中部分与会人员强调AI技术不会导致医护人员失业,相反,它将改变医疗行业的工作方式,创造新的就业机会。AI可以承担一些重复性和繁琐的任务,如数据录入和初步诊断,从而释放医护人员的时间,让他们能够更多地参与到患者沟通、复杂手术和高级护理工作中。此外,随着AI技术的发展,新的职业角色如AI伦理顾问、数据分析师和健康信息专家等也将应运而生。

3.AI技术可能削弱医生的临床判断能力,能导致医护人员的就业风险::部分与会人员担忧,过度依赖AI辅助工具可能会削弱医生的临床判断能力。他们认为,医生在长期的临床实践中积累的经验是AI无法完全复制的。AI系统可能在某些情况下提供错误的诊断建议,或者无法理解复杂的临床情境,这可能导致医生对AI的过度信任,从而在没有充分考虑所有因素的情况下做出决策。因此,专家们强调需要对AI技术的局限性有清晰的认识,并在临床实践中保持批判性思维。也有专家指出AI技术可能会对某些医护人员的就业造成威胁。随着AI在诊断、治疗计划制定等方面的应用越来越广泛,一些基础的医疗工作可能会被自动化工具取代。

思辨议题二:如何平衡医生和AI医生的自主权?AI医生出错应该向谁追责?

思辨嘉宾重庆医科大学附属儿童医院麻醉手术中心主任徐颖认为医生应该具有诊断自主权,医生可通过AI医生的诊断进行决策,所以AI出错应该向医生追责。医生具有自己独立的学习曲线,AI医生难以捕获学习无法直接描述的现场特征,现阶段还没有实现医生与AI医生的结合。未来通过提高AI医生诊断的准确性,可促进AI医生和医生的结合,但诊断决策权应该落脚于医生,不应该由AI提供最终决策。特邀嘉宾苏州科技大学吴征天教授表明在使用AI的场景下有几部分实体,医生、开发者、医院等。医生和医院一定要为决策负责,但开发者也需要对模型本身负一定比例的责任。对AI需要进行持续的监控和评估,总的来说:保持医生对患者的最终责任;明确AI作为辅助;建立清晰的法律框架;强化模型本身的透明度和可解释度。与会人员就该思辨点进行了讨论,内容主要包括:

1.医生的决策自主权与AI的辅助角色: 医疗专家们强调,医生的决策自主权是医疗实践的核心,AI技术应作为辅助工具,而不是替代医生的决策。 医生的自主权不仅基于医疗精神,而且其目的是促进患者健康和福祉。因此,AI的使用应设计为促进或至少维持医生的决策自主权,而不是削弱它。

2.AI技术的责任归属问题: 讨论中提到,当AI技术出错时,责任归属可能涉及多个方面,包括开发人员、医疗机构和临床医生。 由于AI的发展涉及多个部门的贡献,责任分配在法律和道德上都具有挑战性。WHO指南指出,责任不应仅由临床医生承担,因为AI技术的不透明性和自我发展特性可能导致“责任缺口”。

3.AI技术透明度和可解释性的重要性: 专家们呼吁AI技术应具备透明度和可解释性,以确保医生能够理解AI系统如何将数据转换为决策。 这种透明度有助于在AI出错时,明确责任归属,并确保医生能够根据专业知识和判断做出最终决策。

思辨议题三:如何定义AI医生决策规则?如何构建AI医生的决策道德?

思辨嘉宾重庆市肿瘤医院/重庆市卫健委数字健康办公室副研究员林博表明从决策的角度来说,认为主要包括准确和最优两个标准,首先需要从评判AI诊疗结果的准确性,其次才能从监管单位的合法性、医疗的成功率、患者的医疗成本和医疗接受程度来评判最优性。监管单位的合法性影响到接收患者的优先度,医疗成果率可能会影响到医疗资源分配,患者的医疗成本和医疗接受程度可能会影响到患者的接受度。从道德上来说,认为主要是以公平为标准。是否能够减少如患者承受能力、医院盈利能力、数据偏移分布可能会存在对患者存在诊断失误等带来的不公平的情况。从决策路径上来说,决策路径目前是黑盒子,决策路径符合世俗道德最大可能决定了其道德性。特邀嘉宾中国科学院重庆绿色智能技术研究院刘曙光高级工程师表明在设计医疗AI系统时,建议为手术机器人设置一个特殊的开关,作为紧急情况下的人为干预机制。该开关仅由医院的特定人员掌控,用于在特殊情况下替代AI决策,而在非紧急情况下仍由AI独立运行,以此平衡AI自动化与人为决策的灵活性。与会人员就该思辨点进行了讨论,内容主要包括:

1.AI技术对医疗决策的影响: 思辨中,与会人员讨论了AI技术对医疗决策的影响,包括可能的自动化偏见和对患者自主权的威胁。与会人员达成一致意见,医疗人工智能的应用需要调整现有医疗伦理规范,以适应AI技术的特点和应用需求,确保患者的基本权利不因技术进步而被削弱。

2.明确AI医生的决策边界: 与会人员一致认为,定义AI医生的决策规则首先需要明确其在医疗决策中的边界。AI医生应被设计为辅助工具,其决策应限于数据分析和模式识别,而最终的临床决策权应保留给人类医生。这要求在AI系统中嵌入明确的规则,以确保其建议不会超越辅助角色。

3.伦理框架与责任归属: 思辨中,与会人员讨论了构建AI医生决策道德的伦理框架,包括责任归属问题。在AI医生的决策过程中,需要明确谁对决策结果负责,这可能包括AI开发者、医疗机构、监管机构和临床医生。伦理框架应指导AI医生的设计和使用,确保其符合医疗伦理标准,并在出现问题时提供明确的指导。

4.AI医生的决策道德具有广义性:部分与会人员认为AI道德问题是一个AI广义的安全问题,包括可信、可管、可控,可信要做到可溯源,可管是监管部门可以认定AI系统符合适用性、能用性、合理性等,可控是AI系统不是一个独立运行系统。从应用角度来看,AI的价值应在于辅助医生快速分析和判断病情,而非取代医生进行伦理层面的决策。实际医疗中,医生的核心难点在于判断和分析,AI应通过整合更多信息帮助抓住病情要点,而最终决策仍需由医生完成。因此,当前讨论的AI伦理问题对实际应用价值有限,关键在于开发能够增强医生效率的辅助型AI,而非替代型AI。

最后,论坛执行主席陈芋文对本次论坛进行了总结,CCF YOCSEF重庆主席胡春强对来自高校、科研院所、医疗单位和企业界的相关专家学者40余人表达了致谢。