中国计算机学会青年计算机科技论坛成都分论坛

CCF YOCSEF Chengdu

2018年11月20日(星期二)13:30—17:40

四川省成都市四川大学望江校区基础教学楼B座302

敬请光临

论坛主题

智能视觉前沿发展技术报告会

报告会简介

目前随着人工智能发展,“智能”时代来袭,智能视觉成为未来发展的一大热门。智能视觉主要用计算机来模拟人的视觉功能,具有人脑的一部分功能,即从客观事物的图像中提取信息,进行处理并加以理解。智能视觉既是工程领域一个热门话题,也是科学研究中的一个重要研究领域。为了更好的促进相关技术和科学研究的发展,CCF YOCSEF成都将于11月20日举办“智能视觉前沿发展”学术报告会,邀请各位人工智能相关领域专家、学者分享在智能视觉、人工智能及相关前沿领域的最新研究和行业应用,并对如何开展本领域前瞻性的研究等进行探讨。

程 序

13:30-13:50会议签到

13:50-14:00 领导致辞

主持人:段磊

14:00-16:40 智能视觉前沿发展技术报告会

主持人:段磊 杨阳

报告一:报告题目:可微编程与数据恢复

特邀讲者:刘光灿教授 南京信息工程大学

报告二:报告题目:迁移学习与领域自适应算法

特邀讲者:张 磊 研究员 重庆大学

15:10-15:30茶歇、合影

报告三:报告题目:密集图像计数中的学习策略研究

特邀讲者:刘凌峤讲师 阿德莱德大学

报告四: 报告题目:Recent Advances in Zero-Example Video Retrieval

特邀讲者:李锡荣副教授 中国人民大学

16:40-17:40 Panel 环节:关于智能研究中的伦理讨论

主持人:朱国斌 电子科技大学信息与软件工程学院党委副书记

CCF YOCSEF成都 主席

17:40-18:00 会议总结

说明:具体会议流程以现场为准

执行主席: 彭玺研究员,四川大学

CCF YOCSEF成都AC委员

杨阳教授,电子科技大学

CCF YOCSEF 成都学术秘书

参加人员:模式识别、计算机视觉、机器学习、人工智能、计算机应用技术领域专业人士,研究生及其他感兴趣者。

参会方式:

1、CCF会员凭会员证免费参加;受邀嘉宾、活动承办和协办单位人员、媒体免费参加;

2、非CCF会员,请办理入会手续,即可免费参会。会费:学生50元/年,专业会员:200元/年,缴费方式:http://web.ccf.org.cn/CCF/regTo.action?flag=0;

或通过扫描二维码进行注册:

3.请点击链接报名参加:https://q.eqxiu.com/s/bbJvvfyY

联系人:屈红艳 Email:qhysxxj@qq.com; Tel: 15982159574

如参会,请于11月15日前回复参会回执至qhysxxj@qq.com;,以便提供会务。

参会回执:

姓名 | 工作单位及职位 | 联系电话 | 邮箱 | CCF 会员号 |

会议地址:四川省成都市四川大学望江校区基础教学楼B座302

乘车线路:

1. 从成都双流机场出发:可乘坐地铁10号线-地铁3号线(磨子桥C口)到达四川大学望江校区附近

或可乘坐机场专线1号线到达四川大学望江校区附近

2. 从成都东站出发:可乘坐地铁2号线-地铁3号线(磨子桥C口)到达四川大学望江校区附近

或可乘坐地铁2号线-92路公交车到达四川大学望江校区附近

特邀讲者介绍

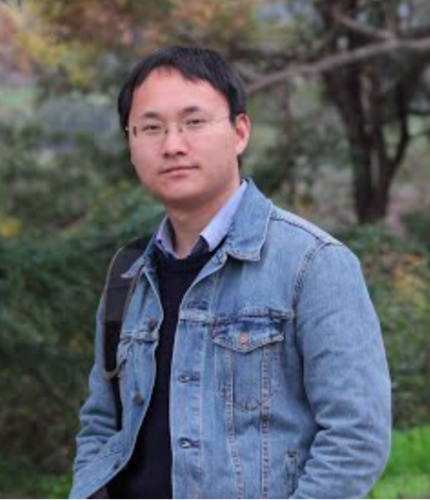

特邀讲者 刘光灿

刘光灿,男, 2004年在上海交通大学数学系获理学学士学位,2010年在上海交通大学计算机科学与技术系获工学博士学位。2010至2014年间,先后在新加坡国立大学、美国伊利诺伊大学香槟校区、美国康奈尔大学从事博士后研究工作。2014年回国,加入南京信息工程大学自动化学院,任教授,博士生导师。 主要研究领域是机器学习与计算机视觉,近年来在机器学习理论与应用方面做了较为广泛的研究,发表论文40余篇(其中第一作者IEEE T-PAMI 4篇),Google Scholar引用4000多次。入选国家优秀青年基金、与江苏省杰出青年基金, 获吴文俊人工智能科技奖 (优秀青年奖)、与教育部自然科学二等奖(排序2), 入选科睿唯安(原汤森路透)ESI高被引学者榜单。

报告主题:可微编程与数据恢复

报告摘要:近年来,随着计算能力与数据规模的提升,机器学习方法的性能有了很大提升。但是,从理论上讲,现有方法仍然不能很好地处理训练集与测试集之间的差异,泛化能力较弱。将介绍两种提升机器学习泛化能力的方法:可微编程(Differentiable Programming/DP)与数据恢复(Data Recovery/ DR)。通过增加网络模型的动态性,可微编程有可能提升神经网络的泛化能力。数据恢复(即:恢复数据的本元状态,以达到简化数据结构的目的),能有效降低数据的差异性,也是提升泛化能力的可行思路之一。将和大家交流可微编程与数据恢复领域的若干研究进展,主要包括低秩矩阵完成与恢复、低秩表示、低秩字典学习等理论框架,以及图像去遮挡、关照校正、几何校正、姿态校正、视觉关注点检测、图像分割等应用性问题。

特邀讲者 张磊

张磊,重庆大学微电子与通信工程学院研究员,博士生导师,重庆市生物感知与智能信息处理重点实验室副主任,LiVE智能学习与视觉团队负责人(www.leizhang.tk),CCF计算机视觉专委会委员,CAAI智能服务专委会委员,CSIG多媒体专委会委员,Valse执行领域主席委员会委员,IEEE Senior Member。2013年博士毕业于重庆大学,2013年6月至9月在清华大学(深圳)、哈尔滨工业大学(深圳)访问交流,2013年10月至2015年9月为香港理工大学计算机系博士后研究员,2017年12月至2018年5月为澳门大学计算机与信息科学系访问学者。主要聚焦于迁移学习、深度学习、跨领域视觉大数据建模与理解和机器嗅觉与味觉方面的智能理论与应用研究等,部分仿生技术和算法已产品化。主持国家自然科学基金(青年和面上)、重庆市人工智能重大专项、重庆市留学生创新创业支持计划等研究项目14项;目前已在IEEE TNNLS、TIP、TMM、TCYB、TIM、TSMCA、TCBB以及ICCV、ACM MM、AAAI、ACCV、IJCNN等会议上发表论文70余篇,中科院一区论文13篇,3篇论文入选ESI高被引论文,2篇入选ESI热点论文,出版英文专著1部,发明专利15项。谷歌学术他引800余次。曾担任WRJB期刊主编和JECE期刊首席客座编辑;担任20余个国际学术会议IEEE TENCON/ICONIP/SSCI/ICCT等会议的最佳论文奖评审主席、荣誉主席、分会主席、地区主席、特邀讲者;担任IEEE TIP/TNNLS/TIE/TCYB/TMM/TIM/TCSVT/TSMCA/TCAS/PR等50余个国际期刊审稿人。曾获CCBR最佳论文奖、香江学者奖、重庆市优秀博士学位论文奖、杰出审稿人奖、重庆市自然科学优秀学术论文奖、重庆大学黄尚廉院士青年创新奖等,并于2013年入选香江学者计划,于2015年入选重庆大学“百人计划”。

报告主题:迁移学习与领域自适应算法

报告摘要:机器学习在人工智能研究和应用中起着至关重要的作用。然而,建立有效的机器学习模型需要大量标记的训练数据,而特定目标领域的数据标记过程需要耗费大量的人力物力,且十分耗时。因此,通过利用相关的且已标记的源域数据辅助模型的训练和学习,用于标记样本稀缺或完全无标记的弱标记目标域数据的精确识别已成为主流。随着大数据的爆炸式增长,数据的异质性日益突出。随之而来的问题是多域数据的独立同分布(i.i.d.)假设不成立,从而导致传统的机器学习性能下降或失效。近年来,用于解决标记数据稀缺和域间分布差异化问题的迁移学习(TL)和领域自适应(DA)作为典型的弱监督学习范式受到了极大的关注,并在很多智能化应用中包括图像识别、人脸识别、自然语言处理、遥感数据分析、医学图像分析、虚拟现实等领域取得了巨大的成功。本报告中,将介绍迁移学习/领域自适应的概念基础和过去10年来最新研究进展。此外,将介绍我们近年来在TL / DA方面的研究工作,包括分类器自适应模型,子空间重建迁移学习,流形准则迁移模型,自我对抗迁移网络。最后,将简要介绍我们提出的一种新的学习范式,即引导式学习,并用于异构视觉识别和检索。

特邀讲者 刘凌峤

刘凌峤,博士,现为阿德莱德大学讲师(lecturer)。他在澳大利亚国立大学取得博士学位。其主要研究兴趣为计算机视觉与机器学习。他在计算机视觉和机器学习顶级会议(如CVPR, ICCV, NIPS, ECCV)以及期刊(如TPAMI, IJCV)上发表论文共40余篇。他于2016年获得由澳大利亚研究理事会颁发的Discovery Early Career Researcher奖。

报告主题:密集图像计数中的学习策略研究

报告摘要:密集图像计数旨在通过图像内容预测图像中物体的个数, 现有的方法通常将该问题转化为一个密度图回归问题。本报告将介绍我们最近的两份关于密集图像技术的工作,它们都着眼于计数模型的学习策略。其中第一份工作提出在原有回归问题上增加一个辅助学习任务,并将辅助任务的预测结果结合起来帮助最终的密度图估计。第二份工作考虑的是如何是用半监督策略来学习计数模型,其优势是使用半监督策略可以极大的减小标注的工作量。 在这份工作中,我们提出一种新的学习目标来指导计数模型的学习。

特邀讲者 李锡荣

李锡荣,中国人民大学副教授、博士生导师。分别于2005年、2007年获清华大学计算机专业本科、硕士学位,2012年获荷兰阿姆斯特丹大学计算机博士学位。同年5月份加入中国人民大学数据工程与知识工程教育部重点实验室,任讲师。2016年晋升副教授,2017年晋升博导,并入选中国人民大学首批杰出学者支持计划。主要研究领域是人工智能与媒体计算。在相关领域主要国际会议和期刊发表论文50 余篇,Google scholar被引用数 2000 多次,H指数21。获ACM MM 2018 Hulu Challenge优胜奖、2017中国多媒体大会优秀论文奖, ACM MM 2016 Grand Challenge Award、PCM 2016 Best Paper Runner-up, ACM SIGMM 2013 Best PhD Thesis Award、IEEE Transactions on Multimedia 2012 Best Paper Award、CIVR 2010 Best Paper Award。曾任ACM MM 2018、ICPR 2016 Area Chair。中国计算机学会多媒体专委会委员。

报告主题:Recent Advances in Zero-Example Video Retrieval

报告摘要:Zero-example video retrieval is a challenging problem in the multimedia field. In such a retrieval paradigm, an end user searches for unlabeled videos by ad-hoc queries described in natural language text with no visual example provided. The majority of existing methods are concept based, extracting relevant concepts from queries and videos and accordingly establishing associations between the two modalities. In this talk we introduce two recently developed concept-free methods. The first method is Word2VisualVec++, a super version of Word2VisualVec. For a given sentence, Word2VisualVec projects it into a deep video feature space by first vectorizing the sentence by a multi-scale encoding strategy. The encoding result then goes through a multilayer perceptron (MLP) to produce a feature vector. The network is trained such that the Mean Square Error (MSE) between the feature vector of the sentence and the feature vector of a video the sentence is describing is minimized. Word2VisualVec++ improves over Word2VisualVec by substituting an improved marginal ranking loss for the MSE loss. The second method is a dual dense encoding network. The network encodes an input, let it be a video or a natural language sentence, in a dense manner. In particular, by jointly exploiting multi-level encodings including mean pooling, GRU and GRU-CNN, the network models explicitly global, local and temporal patterns in both videos and sentences. As such, a given video / query is encoded into a powerful representation of its own. The effectiveness of the two methods is verified by the very recent NIST TRECVID challenge, by winning both the TRECVID 2018 Ad-hoc Video Search (AVS) task and Video-to-Text (VTT) Matching and Ranking task.