2025年12月20日,由中国计算机学会(CCF)主办、CCF YOCSEF西安分论坛组织的“AIGC 安全测评:破局乱象·重塑信任”技术论坛在西安软件园成功举办。本次论坛由CCF YOCSEF西安AC委员张佳龙、童小敏共同担任执行主席,汇聚了来自高校科研机构、互联网头部企业、人工智能安全公司及国家标准化机构的40余位专家学者。与会嘉宾包括来自复旦大学、香港大学、南京大学、西安交通大学、京东集团、中国电子技术标准化研究院、北京极智信科技有限公司等单位的专家代表。同时,YOCSEF 重庆、南京等兄弟分论坛到场支持。

论坛面向生成式人工智能加速进入金融、政务、医疗等高责任应用场景的现实背景,聚焦当前AIGC安全测评中普遍存在的体系割裂、方法分散、结果难以采信等突出问题,围绕“测得多,就够了吗?”“什么是好的评估体系?”“测得好,就信得过吗?”三大思辨议题展开深入探讨,系统梳理AIGC安全测评面临的关键挑战,探索可复现、可采信、可演进的测评体系构建路径,为AIGC安全测评的技术方法与治理机制厘清方向、凝聚共识。

共识速递:

共识一:AIGC 安全测评正从“能力展示”转向“风险覆盖”,数量繁荣不等于风险充分识别

论坛认为,当前测评实践呈现出明显的“数量扩张”特征,但测试集同质化、评测目标重复、对真实高风险场景与复杂应用形态覆盖不足的问题并存。“测得多”并未自动转化为“测得对”,大量测评结果难以支撑有效的风险研判,反而加剧了结果不可比、不可复核的现实困境。

共识二:“好的评估体系不是单一标准,而是分层、分类、可演进的系统工程

论坛认为,不同应用场景、行业属性与风险等级决定了评估体系不能“一刀切”。有效的评估体系应在国家治理框架下,形成统一安全底线 + 行业差异化要求 + 场景定制化约束的多层结构,并在技术可行、经济可承受、责任可界定之间取得平衡,允许随着模型形态与应用方式演进持续修正与迭代。

共识三:安全测评的工程定位是“守住安全底线”,而非“形成安全背书”

来自企业与研究机构的实践共识表明,即便通过既有安全测评,模型在实际部署中仍需结合运行态防护、持续监控与策略约束。测评结论的核心价值,在于为风险管理与治理决策提供输入,显著降低系统性与致命性风险,而非对模型安全性给出确定性背书。

共识四:在缺乏“可信根”的现实条件下,可信测评必须从“信模型”转向“信机制与环境”

论坛认为在当前阶段,大模型安全测评尚难建立类似传统安全体系中的可信根,绝对可信的测评结论并不现实。可信测评的可行路径,不在于一次性建立信任,而在于通过可验证、可审计、可监督的测评机制设计,并结合可信执行环境、零知识证明等技术手段,在不暴露模型与数据细节的前提下持续压缩不可验证空间,为高风险应用构建可治理、可追责、可演进的安全边界。

精彩回顾:

论坛伊始,两位执行主席介绍了YOCSEF的文化理念及本次论坛的背景与目标,指出在大模型能力快速跃迁、应用形态持续扩展的背景下,安全测评已成为连接技术创新、工程落地与治理要求的重要枢纽,亟需在方法论与机制层面进行系统性反思与重构。

接下来,四位引导发言嘉宾分别从高校研究、产业实践、标准治理与企业防御体系等维度展开分享,为后续思辨讨论奠定了坚实的技术与制度基础。

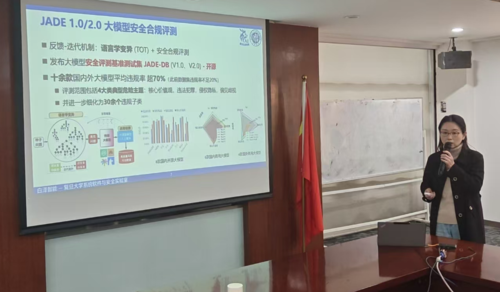

1) 复旦大学 张谧 :大模型安全风险测评方法一JADE助力负责任AI

张谧指出,强化学习、思维链等机制与大模型结合,使模型展现出更强的推理与自主决策能力,也带来了模型自身安全与生态安全的新风险。她系统介绍了 JADE 自上而下、面向全类别的靶向式安全测评方法,涵盖多模态、Agent、推理链等关键形态,并通过大规模实证评测揭示了当前主流模型在幻觉、投毒与推理违规等方面的共性风险。相关工作强调测评体系应具备开源、通用、可迁移与持续演进能力。

2) 北京极智信科技有限公司 孙明亮: 大模型安全全周期 '三位一体'治理

孙明亮指出,人工智能安全已成为国家总体安全的重要组成部分,大模型安全监管在法律法规层面具有全周期、全行业、全链条的强制性要求。面对大模型数量快速增长和安全事件频发的现实挑战,他提出以安全评估、安全防护与人才培养“三位一体”的全生命周期解决方案,其中安全评估是发现风险、支撑监管的基础环节。围绕输入与输出两类核心风险,针对评估广度、深度、准确性、时效性及智能体多接口等难题,团队构建了覆盖多应用场景的大模型防火墙,并强调通过实战化靶场与体系化培养机制,持续夯实我国大模型安全能力建设。

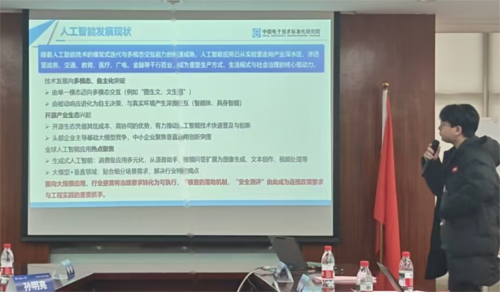

3) 中国电子技术标准化研究院 吕飞霄:AIGC安全测评体系构建研究标准化路径与实践思考

吕飞霄认为,在人工智能快速迭代与多模态能力不断增强的背景下,安全测评已成为将治理要求转化为工程实践的关键抓手。面对风险类型复杂、场景差异显著的挑战,测评需要以标准体系贯通为核心,将安全要求细化为可执行、可核查的指标与判定口径,并通过多维度评估真实刻画模型安全状态。通过标准化、可复核、可互认的测评机制,持续完善指标、用例与工具能力,为AIGC的可信应用提供基础支撑。

4) 京东集团 张安蒙:京东大模型防御体系介绍

张安蒙指出,随着大模型应用从单一对话形态演进至智能体与复杂业务流程,安全威胁正由传统越狱攻击转向Agent劫持、数据投毒等新型风险。京东构建了以“AI 防护 AI”为核心的全生命周期、纵深防御体系,从事前、事中到事后覆盖数据投毒、Agent攻击与后门风险,并在在线推理、流式输出、RAG与Agent 运行等场景中形成系统化防护能力。针对安全评测中数据稀缺、动态对抗、多模态与标准不统一等挑战,京东进一步引入态势感知、红队与安全审核等智能体,探索以体系化评测支撑大模型安全防御的工程路径。

思辨讨论:

议题一:测得多,就够了吗? ——回溯测评乱象,厘清测评困局

核心结论:当前测评“数量繁荣”并未等价于“风险覆盖充分”,测评正面临“同质化过剩”与“关键风险不足”并存的结构性问题。

讨论要点总结:

l 测试集数量激增,但有效挑战性不足

Ho Chen 指出,随着模型能力快速提升,传统测试集正在被“做穿”,测试集是否仍具备区分度与挑战性,已成为比“数量”更关键的问题。

l 同质化测评难以反映真实风险分布

多位嘉宾指出,不同测评之间在数据来源、方法设计上高度重叠,导致“看似测了很多,实则反复验证同一类问题”。

l 通用测评无法替代专用场景测评

来自企业与标准机构的观点认为,金融、政务、军事等场景关注的风险侧重点高度不同,通用数据集对专用领域的指导意义有限。

l 测评、检测、评估概念混淆,加剧行业困惑

孙明亮指出,当前部分实践混淆了检测、评估与测评的概念,导致对“测得多”的理解本身就存在偏差。

l 测评体系成熟需要过程,而非一蹴而就

与会嘉宾普遍认为,大模型测评正处于探索期,当前暴露的问题本身正在推动体系加速演进。

议题二:什么是好的评估体系,以及如何构建?——探寻系统化测评体系之路

核心结论:好的评估体系不是“测得最全”,而是能够在技术可行、经济可承受、责任可界定之间取得平衡。

讨论要点总结:

l 评估体系必须同时算清“三本账”:技术账、经济账与责任账

徐翔宇提出,评估不仅要“能测、测好”,还要考虑企业成本与责任归属,否则难以落地。

l 评估应以国家治理框架为锚点,而非碎片化生长

吕飞霄强调,应在国家统一框架下形成基础共性要求,再向行业与场景下沉,避免评估体系各自为政。

l 评估体系必须允许“动态修正”,而非一次性定型

多位嘉宾指出,评估应从实践中发现问题、修正标准,而不是试图提前定义“完美体系”。

l 数据是评估体系中最难,也最核心的约束条件

企业与学界普遍反映,高风险、恶意数据难以公开获取,评估体系建设需正视数据合规与现实约束。

议题三:测得好,就信得过吗?——探索可信测评机制的构建路径

核心结论:在当前阶段,大模型安全测评尚难建立类似传统安全体系中的“可信根”,绝对可信的测评结论并不现实;可信测评的可行路径,不在于一次性建立信任,而在于通过机制设计、可信环境与技术手段的协同,引导测评结论在可验证、可监督的前提下,持续压缩不可验证空间,为高风险应用提供可治理的安全边界。

讨论要点总结:

l 静态、公开测评难以支撑对大模型的长期可信判断

在评测规则与数据高度透明的情况下,模型可能出现“针对评测目标优化”的行为,使公开测试结果与真实运行风险之间产生偏差。同时,基于静态数据集与一次性评测的方式,难以适配大模型能力持续演化、多模态扩展与使用方式变化的现实,测评结论在时效性与外推性上均存在明显局限。

l 缺乏“可信根”决定了测评无法提供严格意义上的安全证明

与依托硬件信任链或物理边界的传统安全体系不同,大模型在当前阶段尚不存在可类比的可信基或可信根,测评难以形成可形式化验证的安全保证。因此,大模型安全测评更接近于风险刻画与安全边界约束工具,而非能够给出确定性“安全证明”的机制。

l 测评的工程定位是“守住安全底线”,而非“形成安全背书”

来自企业侧的实践经验表明,即便通过既有安全测评,模型在实际部署中仍需结合运行态防护、持续监控与策略约束。测评结论更多作为风险管理与治理决策的输入,而非对模型安全性的背书性证明,其现实价值在于显著降低系统性与致命性风险,而非穷尽所有潜在问题。

l 可信测评的现实路径正在从“信模型”转向“信机制与环境”

在缺乏模型可信根的前提下,论坛认为,可信性的可落地方向应更多依赖测评过程与测评环境本身的可信性,包括流程是否可审计、结论是否可复现、过程是否可监督。围绕跨主体测评中的数据不可共享与结论难以互认问题,与会嘉宾提出可探索结合可信执行环境、零知识证明等技术路径,在不暴露模型与数据细节的前提下,实现测评过程与结果的可验证性,为多主体参与的可信测评提供工程化支撑。

论坛总结:

论坛最后,YOCSEF西安(2024-2025)主席宋霄罡作总结发言。他指出,本次论坛围绕 AIGC安全测评的技术方法、工程实践与治理机制展开了系统而深入的讨论,不同背景嘉宾在多个关键问题上形成了富有张力的观点交锋与理性共识。论坛不仅梳理了当前测评体系面临的现实困局,也对可信测评机制的可行路径进行了前瞻性探讨,为后续相关研究与实践提供了清晰的问题框架与思考方向。

记录:张海曦、叶贵鑫

撰写:张佳龙、童小敏

校对:许鹏飞、杨旭东、王鸽