CCF YOCSEF青岛举办“迈向情感智能的多模态交互技术的进展与挑战”技术论坛

随着大规模预训练模型、语音语言与视觉技术的日趋成熟,人机交互正在从语音交互演进至多模态交互。多模态交互是否能够成功迈入情感智能时代,是当前产业界和学术界面临的重大课题。在此背景之下,2023年2月25日中国计算机学会(CCF)青年计算机科技论坛青岛分论坛(YOCSEF 青岛)在青岛市崂山区海信新研发中心举办《迈向情感智能的多模态交互技术的进展与挑战》的技术论坛。本次论坛由中国计算机学会主办,由CCF YOCSEF青岛学术委员会、海信电子信息集团研发中心、青岛洞听智能科技有限公司、海信集团产业拓展重点实验室协办,青岛希诺智能科技有限公司赞助。YOCSEF青岛AC委员杨善松(海信视像科技股份有限公司)与 YOCSEF青岛候任AC委员于昕(青岛洞听智能科技有限公司)共同担任执行主席。

出席本次论坛活动的专家有哈尔滨工业大学车万翔教授、清华大学黄民烈长聘副教授、哈尔滨工业大学赵妍妍副教授、哈尔滨工业大学(威海)晁国清副教授、山东大学高莘助理教授、小米AI实验室人机对话负责人刘伟、流利说首席算法架构师张潇君、洞听智能首席科学家李曙光、思必驰公司对话交互资深工程师林永楷、海信视像科技高级工程师马明。青岛市人工智能产业协会秘书长张代楠出席本次活动并致辞。YOCSEF总部副主席贺瑞君、YOCSEF上海AC委员马骏、YOCSEF青岛主席包永堂、YOCSEF青岛AC委员,及青岛、烟台、威海等地的高校教师与企业专家,共计80余人线下参加此次活动,线上共计400余人观看直播并讨论交流。

本次论坛围绕多模态交互技术如何促进情感智能的进展、挑战、发展趋势和产业应用展开充分、热烈的交流和思辨。引导发言阶段,共计有四位引导发言嘉宾,分别是清华大学黄民烈、哈尔滨工业大学赵妍妍、小米AI实验室刘伟、流利说张潇君。

黄民烈以“数字生命与ChatGPT”为题,介绍了当前火爆全球的ChatGPT的原理与技术,不足与缺陷。结合他在对话系统、大模型上十多年的研究积累,以及其在创业公司产品“AI乌托邦” (基于大模型的拟人化对话引擎)上的深度实践,提出人工智能已经进入新时代,人工智能不仅仅需要信息搜索与获取能力的“智商”,也需要有社交能力的“情商”。在人工智能新时代,人类社会如何与数字生命共存?这个问题将需要我们整个学术界和产业界的在人工智能的情商与智商两个方面都做出努力。

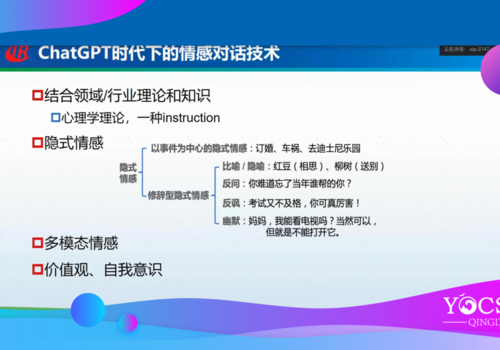

赵妍妍认为情感对话技术着眼于对话机器人的“情商”,旨在让对话机器人具有像人类一样观察、理解和表达情感的能力。该技术是情感计算和对话技术的交叉,兼顾对话机器人的“智商”和“情商”,从而实现对用户的精神陪伴、情感慰藉和心理疏导。赵妍妍同时结合对话中情感的特点,对情感对话技术进行全面解析,重点介绍了对话场景下的情感感知、情感认知、共情表达等三个重要的技术点,以及多模态场景下的情感对话技术。赵妍妍认为在当前ChapGPT技术框架下如何做纯文本的情感对话技术是一个重大的技术课题,面临的挑战包括隐式情感、多模态情感、价值观和自我意识的有效建模。

刘伟从小爱同学情感对话实践出发,指出中国有超过9500万抑郁症患者,其中九成以上都没有接受正规治疗(坚持吃药+心理咨询);同时以小爱同学为代表的智能语音助手已经深入到普通人的日常生活,每天都有海量的用户和语音助手交流,并表达自己的情绪。小米联合北京大学心理系,提出搭建心理援助体系以外的“日常陪伴与自我关照”支持体系,从压力早期接入,通过情绪感知的对话系统为人们提供日常情绪疏导和情感陪伴,提升人们心理健康素养。此外他还介绍了小爱同学情感对话的相关实践,包括情绪理解、共情对话和情绪疏导等方面。

张潇君认为语言学习的过程需要大量的对话交互,针对不同年龄不同诉求的用户,其团队实验了不同模态的交互方式。针对AI老师的温度和情感能力的建设,需要按照听(语音识别)、说(语音合成)、理解(即自然语言理解)、灵敏(全双工交互)、虚拟形象(计算机图形)、思考创作与共情等不同层次进行构建。

思辨环节围绕三个议题展开,分别是议题1:面向情感理解能否构建多模态融合框架,面临的问题和挑战有哪些;议题2:情感交互的核心是共情反馈,如何引入心理学、常识、用户画像等知识;议题3:如何将情感因子融合进语言、语音表达和形象呈现等多模态内容生成中。

围绕第一个议题,车万翔和林永楷分别进行思辨发言。车万翔认为必须构建多模态融合框架,只有通过语音、视频、表情的多模态融合才能更好的进行情感对话。目前ChatGPT比较好的解决了语义、推理问题,后面下一阶段的语用问题,不仅需要文本,更需要多模态。林永楷认为多模态情感融合,能够一定程度上解决单模态无法解决的问题,但是目前多模态框架仍面临大量挑战,包括:模型表征融合带来的计算复杂度高、跨域泛化能力弱、多模态数据集匮乏、情感建模的粒度粗糙等挑战。包永堂认为,情感计算仅在单一文本模态上难以突破,需要进行融合决策。于彦伟认为,虽然ChatGPT目前比较火,但是仅建模单模态,特别是需要融入伦理、常理等信息。王莹洁与刘伟都认为模型融合最难,文本、语音、视频已有在做,新模态(如生理信息)加入后对多模态融合带来新挑战。仲国强认为近期多模态融合受限于算力、数据集、推理时间、场景、个性化需求等,短期内无法达成。

围绕第二个议题,高莘和李曙光分别进行思辨发言。高莘认为研究情感交互的原因首先要知道它的诱因及知识,此外是心理学和用户画像。如何引入场景情感交互是另外一个值得探讨的话题,但是大模型时代,无法直接fine-tuning,需要通过下游任务进行改进。此外,可以通过大模型小模型交互,让它们进行交互,大模型知识蒸馏得到小模型。李曙光认为目前直播电商等领域都在引入多模态,如场景理解、语音声调、情感交互等,但是多模态融合仍有很长的路需要走。张晓伟、赵妍妍等认为图像融合的挑战更大,提升情感感知和识别需要更细粒度的刻画,才能实现共情;常识需要引入心理学,认知心理学是偏实验,因此方便我们通过实验引入。ChatGPT出现后,通过更细的引导后,就能学会所谓的心理学模型。模态的可靠性很重要,ChatGPT是一个反馈机制,反馈机制融合心理学比较重要。具体业务和场景捕捉能弥补语音方面的缺陷,因为通过语音捕捉情感比较困难。

围绕第三个议题,晁国清和马明分别进行思辨发言。晁国清肯定了语言表达和形象表达等对情感表达的重要性,因为人的情感呈现本就是由文本呈现、语音表达、表情手势肢体传达等方式呈现的,即多种模态的呈现。对于每种模态单独的呈现效果都是有片面或有局限性的,所以需要多模态融合,而各种模态的呈现又是靠内容生成来完成的。因此,多模态内容生成是提升情感呈现的必要途径。可以考虑融入情感向量和使用迁移学习把情感因子融合进语言组织、语音表达和形象表达。马明分享了实现六种情绪情感语音合成过程中,发现情感语音合成在海信的语音交互场景中难以落地的现象。刘伟和赵妍妍表示现在大模型背景下,情感因子不是融入,而是怎么用到大模型。仲国强认为ChatGPT是多任务的大模型,针对数字人问题,使用生成式模型,同时生成文字、语音,形象等,应用实践上依旧需要很长的探索之路。宫文娟、于彦伟、李昕也表达了情感分析分成两个层面,一是通用的情感分析;二是个性化情感分析。情感因子融入时可以考虑从这两个层面进行融入。多模态输入本身就有很多模态信息,情感因子应该学习得到,个性化后再做特殊处理体现在多模态信息中。

思辨环节结束之后,CCF YOCSEF青岛主席包永堂以感谢应邀嘉宾、感谢参与人员、感谢组织策划人员的三个感谢作论坛总结,同时也对本次论坛的赞助方青岛希诺智能科技有限公司表达了感谢。此次论坛为高校、研究院所、企业等从事多模态情感智能和人机交互研究的人员提供了很好的交流与思辨机会,推动了相关专家学者对情感智能可行路径的深度思考。历时三个多小时,本次技术论坛在热烈的会场氛围中圆满结束。

本次论坛受到了多家媒体的同时关注,青岛电视总台新闻频道当天对本次活动进行了报道。此次报道也得到了社会各界的积极反馈,截至目前已超过230万总浏览次数。YOCSEF青岛的影响力得到了进一步提升。

欢迎大家继续关注CCF YOCSEF青岛的微信公众号,关注我们的后续活动。

以下是媒体对本次活动的报道。

1. 青岛总台报道视频:

2. 新财经栏目报道视频:

4. 蓝睛短视频的播放链接:https://lanjingapp.qtvnews.com/mobile/html/newAppShare/view/newsDetailsLj.html?appName=lanjing&id=535084&date=1677327618857