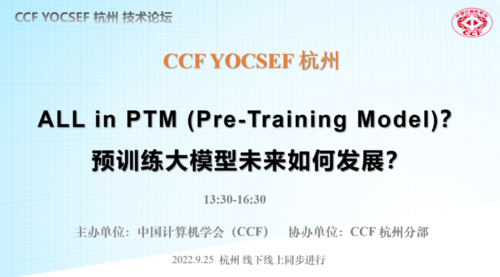

对此,CCF YOCSEF杭州于2022年9月25日举办“ALL in PTM (Pre-Training Model)?预训练大模型未来如何发展?”技术论坛,此次活动采用“线上+线下”的方式进行,线上活动通过腾讯会议平台直播。

图1 “ALL in PTM (Pre-Training Model)?预训练大模型未来如何发展?”技术论坛

论坛由CCF YOCSEF杭州分论坛副主席董建锋和陈亮共同担任现场活动执行主席,来自各个院校和企业代表对预训练模型感兴趣的朋友们共一百多人汇聚线上,就预训练大模型的未来发展话题展开讨论和思辨。

图2 CCF YOCSEF杭州分论坛副主席董建锋和陈亮主持论坛

论坛现场活动包括引导发言和思辨环节两部分。针对论坛主题,现场邀请了3位引导嘉宾和2位特邀嘉宾,他们分别来自使用大规模预训练模型紧密相关的具有代表性的研究院和企业,3位引导嘉宾分别就“基础模型在直播风控场景的实践”、“基础模型与超级深度学习的演进与展望”和“多模态预训练模型的研究与应用”等方面作引导发言。

☆ 引导发言

图3李裕宏在线引导发言

阿里巴巴淘宝直播风控算法负责人李裕宏就《基础模型在直播风控场景的实践》主题进行引导发言,他介绍了直播要素和5大风险,提出了直播风控的3大挑战和应对策略,也带来了一些思考,如大模型如何赋能业务?大模型自身如何快速迭代?以及基础设施与治理问题并给出了自己的见解。

图4王超岳在线引导发言

论坛邀请京东探索研究院多模态大模型负责人王超岳作题为《基础模型与超级深度学习的演进与展望》的引导发言,他中梳理了AI模型呈现螺旋式演进的特征,并指出语言大模型的率先突破是由量变引发质变,视觉大模型的积极探索是有监督走向自/无监督,以及多模态大模型未来展望是迈向模态统一与任务通用。

图5王文海在线引导发言

上海人工智能实验室青年科学家王文海作《多模态预训练模型的研究与应用》的发言。王文海认为通用模型的核心思想是构建一个如人脑一样统一的通用模型,仅使用同一套模型权重,其输入可支持各种模态数据及其组合,其输出可支持各种任务及其组合,取代过去一个任务一个模型的专用感知技术路线;能从海量多模态数据中学习到通用的知识,赋能百行千业;对于标注人员稀缺、采集设备昂贵、采集条件苛刻的任务(如∶智慧医疗、航天、遥感)有极大的意义。

☆☆ 思辨环节

引导发言结束后,论坛进入思辨环节。引导嘉宾、特邀嘉宾及所有的线上线下参会人员从“目前预训练大模型训练效率低、算力消耗大,如何提高模型的易用性?如何从技术上高效、低成本地将预训练大模型广泛地应用于不同领域的实际系统中?”、“现阶段预训练大模型在落地应用中面临哪些安全可信的挑战?在落地应用中实现安全可信预训练大模型的关键方向和技术有哪些?”和“目前的预训练大模型通常缺乏认知能力,如何提升认知能力?”这三个问题展开思辨,表达了各自的观点。

图6 参会人员思辨发言

思辨议题1:目前预训练大模型训练效率低、算力消耗大,如何提高模型的易用性?如何从技术上高效、低成本地将预训练大模型广泛地应用于不同领域的实际系统中?

针对该问题,与会者们展开了激烈讨论。李裕宏认为现在的训练成本的确高,Google提出了通用模型架构,我们团队在底层做了控制算子的优化,可以大幅降低大模型训练和推理成本。王超岳认为对大模型要有可理解和可解释的能力。要让大模型具有持续学习迭代的能力。大模型的部署和应用依赖于开源的生态。建议大模型可以构建成基础的模块供大家调用。王文海提出大模型开源目前做的还不是特别好。开源需要先把市面上主流的数据统筹。大模型的训练,需要探讨大模型的全生命周期学习算法。大模型的通用性目前还未达到预期,仍需要沿着多模态大模型+adapter的范式开展研究。韩蒙指出预训练模型和易用性不是一件事,预训练更关注模型编译器和优化压缩。姚金鑫认为从硬件角度,模型很大的时候,在时效性和内存使用时有瓶颈。需要从系统角度考虑如何提高内存的使用效率,需要同时考虑训练和推理两部分。

思辨议题2:现阶段预训练大模型在落地应用中面临哪些安全可信的挑战?在落地应用中实现安全可信预训练大模型的关键方向和技术有哪些?

针对该问题,与会者李裕宏认为模型安全可信问题,比较关注联邦学习解决数据安全与隐私的问题。应用算法方面,需要做到全链路和全生命周期的可信,实现数据可信,模型可信,平台可信。韩蒙认为大模型存在隐私泄露的问题。关注在建大模型过程中和模型建好后如何实现隐私保护,在安全方面也要考虑实际落地场景。姚金鑫指出在实际应用中对数据的安全要求比较高。大模型在实际部署中,也会被利用做不好的事情。在工业领域,传感器的数据在上传过程中会加密。王超岳指出从内容生成的角度,如何对相关内容进行审查和过滤是我们关注的。王文海补充说大模型数据隐私保护中,我们会在训练之前制定一些规则屏蔽一定数据,在模型训练好后,也需要一些补救措施。董建锋提问相比小模型,大模型鲁棒性是否好一些?是否有一些其他特有安全问题?李裕宏答复指出模型做大之后带来的鲁棒性和泛化性会有大幅提升。大模型在内容生成方面优势很明显,但是其在训练过程中存在很多隐私问题,还有公平性和伦理的问题。韩蒙认为目前公开资料中针对模型有100多种攻击手段和防御手段,但是大模型在安全评测过程中没有表现出特有的优势。大模型的泛化能力强,也带来了更多的攻击机会。华康提问数据不平衡、数据逻辑本身是错的情况下,如何进行学习?韩蒙答复认为在实际中,首先会对数据进行处理,个体的脏数据对大模型的训练结果影响不大。

思辨议题3:目前的预训练大模型通常缺乏认知能力,如何提升认知能力?

针对该问题,与会者王文海认为目前大模型仍要加强感知能力的基础上来提升认知能力。大模型依赖于大量数据,标注成本比较高,数据一般是带噪声和弱标签的,离零样本的期望还比较远。在感知方面,可以考虑更多的任务形式,做更多的零样本预测,也要考虑基于弱标注的模型学习。王超岳认为从生成模型看,模型已经可以通过学习创造出符合语义的内容了,模型的认知能力已经得到了提升。只要脏数据和弱标注数据比例不大的情况下,对模型的鲁棒性和泛化能力影响不大。董建锋指出提升大模型的认知能力需要加强大模型理论基础和可解释性研究。李华康认为提到认知计算和认知智能,认为认知能力是知识粒度的一个评估。如何让大模型具有知识粒度层级的能力比较有挑战。提出可以将知识图谱与大模型结合,提升大模型的认知能力。姚金鑫指出认知本身也是分层次的。评估模型的认知能力,首先需要对认知本身做分层。从应用角度,大模型结合了很多先验知识,这些先验知识对于模型的认知能力提升帮助很大。

☆☆☆ 结论梳理

经过一个下午的深入探讨和热烈思辨,本次技术论坛观点梳理如下:

1.要让大模型具有持续学习迭代的能力,训练需要探讨大模型的全生命周期学习算法,从而降低训练成本。从硬件角度,大模型在时效性和内存使用时有瓶颈;需要从系统角度考虑如何提高内存的使用效率,需要同时考虑训练和推理两部分。在某些场景,也不需要一味追求大模型,最关键的是要在真实场景落地;同时可通过大模型和小模型协同的范式提高模型的易用性。

2.大模型存在隐私泄露的风险。大模型在内容生成方面优势很明显,但是其在训练过程中存在很多隐私问题,还有公平性和伦理的问题。需要关注在建大模型过程中和模型建好后如何实现隐私保护,联邦学习可在一定程度上解决数据安全与隐私的问题。在应用算法方面,需要做到全链路和全生命周期的可信,实现数据可信,模型可信,平台可信。

3. 将知识图谱与大模型结合,引入额外先验知识;加强大模型理论基础和可解释的研究,有助于提升大模型的认知能力。目前生成式大模型已经可以通过学习创造出符合语义的内容,模型的认知能力相比于小模型已经得到了一定提升。

图7 参会人员合影